- Pracowałem z najlepszymi. Możesz mi zaufać.

- 790-768-482

- info@rafalszrajnert.pl

Plik robots.txt -do czego służy?

SEO SEM co to -czym się różnią? Poznaj 3 sekrety i techniki

26 grudnia, 2022Agencja pozycjonowanie stron internetowych -co robi? [przykłady, definicja]

26 grudnia, 2022Plik robots.txt -do czego służy?

Co to jest plik Robots.txt? Definicja.

Zawartość strony

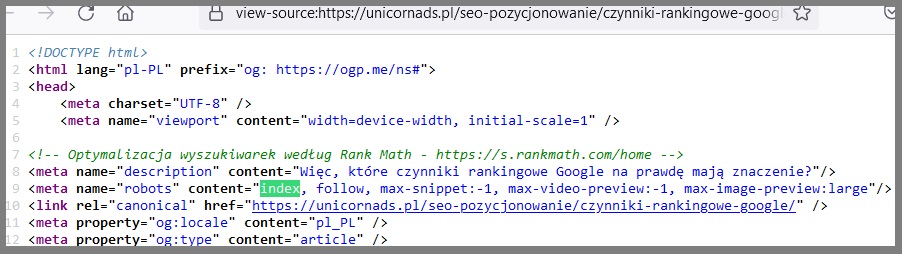

Robots.txt definicja – to plik, który informuje roboty wyszukiwarek, aby nie indeksowały określonych stron lub sekcji witryny. Większość głównych wyszukiwarek (w tym Bing, Google, czy Yahoo) rozpoznaje i uznaje żądania pliku Robots.txt.

Zaufali mi najlepsi:

Dołącz do nas NA DARMOWYM WIDEO

Wpisz Swój Najlepszy Adres Email, Ponieważ Na Niego Dostaniesz Link.

Dlaczego plik Robots.txt jest ważny?

Pliku robots.txt jest ważny, ale nie dla każdej strony. Większość witryn jego nie potrzebuje.

To dlatego, że Google z reguły łatwo znajduje i indeksuje wszystkie ważne strony w Twojej domenie.

Crawlery, czyli roboty indeksujące są na tyle zaawansowane, że automatycznie NIE indeksują stron, które są mało istotne lub powielają (duplikują) wersje innych stron.

Mimo to, istnieją 3 główne powody, dla których chcesz użyć pliku robots.txt.

Zapobiegasz indeksowaniu zasobów: Używanie dyrektyw i wytycznych meta może działać równie dobrze jak plik Robots.txt, jeśli chodzi o zapobieganie indeksowaniu niechcianych stron. Jednak wytyczne meta nie działają dobrze w przypadku wszystkich zasobów. Na przykład możemy mówić o zasobach multimedialnych (pliki PDF i obrazy). W takim przypadku będzie Ci potrzebny prawidłowy plik robots.txt.

Chcesz efektywnie wykorzystać budżet indeksowania (crawl budget): jeśli masz trudności z zaindeksowaniem wszystkich stron, to możesz nieefektywnie wykorzystywać indeksowania. Blokując nieistotne strony za pomocą pliku robots.txt, Googlebot może przeznaczyć więcej crawl budget na indeksowanie stron, które są naprawdę ważne.

![Plik robots.txt -do czego służy? 5 Crawl Budget – czym jest i jak wpływa na SEO? [definicja, przykłady]](https://unicornads.pl/wp-content/uploads/2022/12/crawl-budget-budzet-indeksowania.png)

Chcesz zablokować strony niepubliczne: Czasami w Twojej witrynie znajdują się strony, których nie chcesz indeksować, czyli nie chcesz aby inni mogli na nie trafiać z przeglądarki. Na przykład możesz mieć wersję strony dla subskrybentów Twojej usługi więc nie ma sensu to, żeby ktoś mógł trafić do tych zasobów z Google.

Podsumowując plik Robots.txt informuje roboty wyszukiwarek, aby nie indeksowały określonych stron w Twojej witrynie.

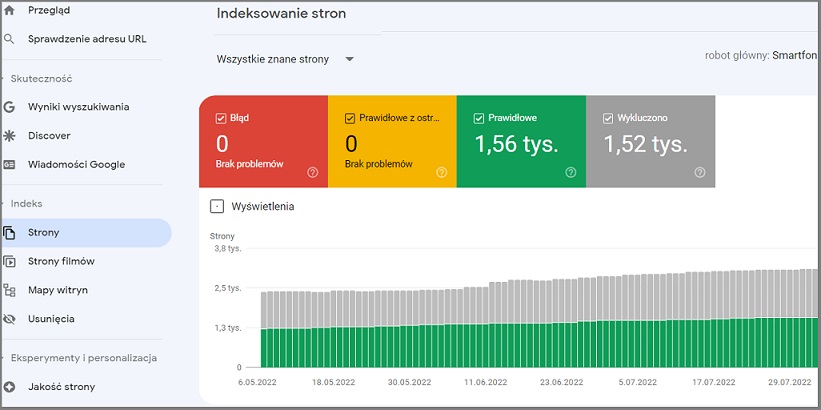

Możesz sprawdzić, ile stron masz zaindeksowane w Google Search Console.

Jeśli robot Google nie zaindeksuje strony, to znaczy, że jej „nie widzi”.

Jeśli liczba stron odpowiada liczbie, które chcesz mieć zaindeksowane to nie musisz zawracać sobie głowy plikiem Robots.txt.

Ale jeśli ta liczba jest wyższa niż oczekujesz i widzisz, że zaindeksowane adresy URL to takie których nie chcesz, to musisz utworzyć plik robots.txt dla swojej witryny.

Zasady tworzenia pliku robots.txt

REKLAMA

Koniecznie zobacz NAJLEPSZE szkolenie z Facebooka na rynku

Link do kursu: szkolenie Facebook Ads

Koniec reklamy.

Utwórz plik Robots.txt

Plik robots.txt w początkowym etapie możesz utworzyć za pomocą Notatnika Windows.

Bez względu na to, za pomoca jakiego narzędzia go stworzysz to, format jest dokładnie taki sam:

User-agent: X

Disallow: Y

User-agent to jeden konkretny bot, któremu chcesz coś zasygnalizować.

Wszystko, co pojawia się po „nie zezwalaj (ang. disallow)”, to strony lub sekcje, które chcesz zablokować.

Możesz także użyć gwiazdki (*), aby komunikować dla wszystkich botów, które odwiedzają Twoją stronę

Oto przykład:

User-agent: *

To tylko jeden z wielu sposobów wykorzystania pliku robots.txt. Google ma nawet oficjalny przewodnik na temat tworzenia różnych reguł, które możesz użyć, aby zablokować lub zezwolić robotom na indeksowanie różnych stron Twojej witryny.

Pamiętaj, żeby Twój plik Robots.txt był łatwy do znalezienia

Po utworzeniu pliku robots.txt musisz go opublikować.

Technicznie rzecz biorąc, możesz umieścić plik robots.txt w dowolnym głównym katalogu swojej witryny.

Aby jednak zwiększyć szanse na prawidłowe odnalezienie i crawlowanie pliku robots.txt, zalecam umieszczenie go od razu po głównej domenie.

Przykład

https://unicornads.pl/robots.txt

U mnie wygląda to tak:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://unicornads.pl/sitemap_index.xml(Pamiętaj, że w pliku robots.txt rozróżniana jest wielkość liter. Upewnij się więc, że nazwa pliku zawiera małą literę „r”)

Sprawdź błędy i pomyłki

Bardzo ważne jest, aby plik robots.txt był poprawnie skonfigurowany. Mały błąd wystarczy, żeby cała witryna została zdeindeksowana.

Na szczęście Google ma bardzo dobre narzędzie do testowania dyrektyw z plików robots.txt.

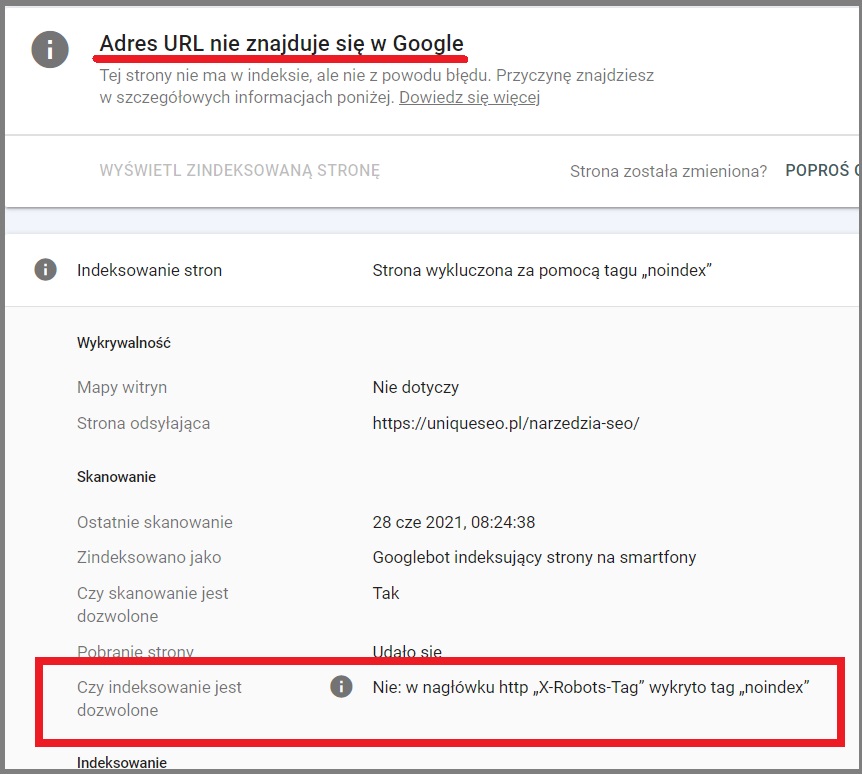

Dlaczego używać pliku robots.txt, skoro możnaz blokować strony za pomocą metatagu „noindex”?

Tag noindex jest trudny do zaimplementowania w zasobach multimedialnych, takich jak pliki PDF i filmy.

Ponadto, jeśli masz setki stron, które chcesz zablokować, łatwiej jest zablokować całą sekcję swojej domeny właśnie za pomocą pliku robots.txt zamiast ręcznie dodawać tag noindex do każdej pojedynczej podstrony.

Podsumowanie

Teraz chciałbym usłyszeć od Ciebie:

Który fragment artykułu był dla Ciebie najbardziej zaskakujący?

A może masz jakieś pytanie.

Tak czy inaczej, zostaw teraz krótki komentarz poniżej.

FAQ – krótkie pytania i szybkie odpowiedzi

Gdzie jest plik robots txt?

Plik robots.txt zwykle znajduje się w głównym katalogu witryny. Na przykład, jeśli adres URL Twojej witryny to www.przykład.com, plik robots.txt znajduje się pod adresem www.przykład.com/robots.txt.

Co myślisz o moim nowym wpisie na blogu?

A może masz pytanie dotyczące strategii lub techniki jak działać najlepiej?

Tak czy inaczej, chciałbym usłyszeć, co masz do powiedzenia.

Więc śmiało, teraz udostępnij ten wpis na swoich social mediach i zobacz co inni mają do powiedzenia.