- Pracowałem z najlepszymi. Możesz mi zaufać.

- 790-768-482

- info@rafalszrajnert.pl

Duplicate content – co to jest powielanie treści?

Ile kosztuje pozycjonowanie strony? [koszt SEO i cennik]

26 grudnia, 2022Seo marketing w wyszukiwarkach – jak zrobić dobrze? (bądź widoczny w internecie)

26 grudnia, 2022Duplicate content – co to jest powielanie treści?

Czym jest duplicate content? Definicja.

Zawartość strony

- 1 Czym jest duplicate content? Definicja.

- 2 Dołącz do nas NA DARMOWYM WIDEO

- 3 Rel = canonical, kanoniczne URL

- 4 Jak prawidłowo tworzyć treść na stronę www?

- 5 Duplicate content w obrębie Twojej domeny

- 6 Jak uniknąć kary za duplikację treści?

- 7 Czym jest Copyscape i jak pomaga w duplicate content?

- 8 Podsumowanie wpisy na temat duplicate content

Duplicate content definicja – to termin, który łączy się bezpośrednio z optymalizacją strony pod kątem wyszukiwarek internetowych.

Zduplikowana treść działa niekorzystnie na stronę internetową i może spowodować jej spadek w rankingu Google i mieć negatywne efekt na SEO.

Za zduplikowaną treść wyszukiwarka Google uważa teksty, które pojawiają się więcej, niż na jednej stronie www.

Warto tutaj wspomnieć, iż identyczna treść może pojawić się w obrębie tej samej domeny lub na innych stronach internetowych (duplikacja wewnętrzna i duplikacja zewnętrzna).

Duplicate content (zduplikowane treści na domenie): Jeśli masz bardzo podobne do siebie strony to może spaść Twoja widoczność.

https://unicornads.pl/seo-pozycjonowanie/czynniki-rankingowe-google/

Zaufali mi najlepsi:

Dołącz do nas NA DARMOWYM WIDEO

Wpisz Swój Najlepszy Adres Email, Ponieważ Na Niego Dostaniesz Link.

Niekiedy treść może być nieznacznie podobna, co będzie jedynie spowodowane przypadkiem, a czasami teksty będą identyczne.

Wyszukiwarki internetowe podjęły walkę z skopiowaną treścią, która godzi nierzadko w prawa autorskie innych osób i nie prezentuje żadnej wartości dla użytkowników Internetu.

Decydujący wpływ ma tutaj wyszukiwarka Google, która na przestrzeni lat wprowadziła liczne zmiany odnośnie oceniania stron internetowych i ich zawartości.

Rel = canonical, kanoniczne URL

Rel = canonical: Czasem witryna może posiadać wiele podstron z podobnymi treściami, a użycie tego tagu pozwala uniknąć duplikacji wewnętrznej i ewentualnej kary od google.

Podobnie do Google działają inne wyszukiwarki internetowe, jak Bing lub Yahoo. Wyszukiwarki internetowe mogą nakładać na strony surowe kary poprzez ograniczenie ich widoczności lub całkowite usunięcie z wyników wyszukiwania.

Nałożona kara skutkuje gwałtownym spadkiem pozycji w rankingu i praktycznie zerową ilością wyświetleń.

Istotną zmianą, która ograniczyła problem związany z kopiowaniem treści od innych twórców, było wprowadzenie przez firmę Google algorytmu o nazwie Google Panda.

Algorytm pojawił się w 2011 roku, gdzie początkowo objął strony funkcjonujące na terenie Stanów Zjednoczonych. Jeszcze tego samego roku firma Google objęła działaniem algorytmu inne kraje, a w tym także Polskę.

Celem algorytmu było wprowadzenie zmiany w sposobie oceniania witryn internetowych i ich contentu.

Roboty sieciowe zaczęły zwracać uwagę na treść, która stała się kluczowa podczas pozycjonowania swojej strony internetowej. Wcześniej właściciele stron www nierzadko stosowali niedozwolone praktyki i manipulowali wynikami wyszukiwania.

W Internecie funkcjonowało wiele serwisów internetowych, które były bezwartościowe z punktu widzenia użytkownika.

Webmasterzy promowali początkowo swoje strony poprzez tworzenie bezwartościowej treści przesyconej słowami kluczowymi. Sytuacja zmieniła się o sto osiemdziesiąt stopni, gdy w życie wszedł algorytm o nazwie Panda.

Strony internetowe o niskiej jakości treści (np. strony thin content, lub farmy treści/content farm) są mniej widoczne w wynikach wyszukiwania po otrzymaniu kary Panda.

Szanse na wysokie pozycje dostały mniejsze serwisy, które były początkowo niewidoczne. Roboty sieciowe zaczęły przyjaźnie traktować witryny internetowe, gdzie pojawiała się regularnie treść, która była unikatowa i wartościowa dla internautów.

Kluczową zmianą było surowe karanie właścicieli stron internetowych, gdzie znajdowała się zduplikowana treść.

Strony posiadające zduplikowaną treść automatycznie było karane i wyszukiwarka Google usuwa je z naturalnych wyników wyszukiwania. W sieci pojawiały się przede wszystkim serwisy, które dbały o jakość dodawanego contentu i udostępniały teksty pisane pod użytkowników.

Algorytm Google Panda był nieustannie rozwijany aż do 2015 roku, gdzie wprowadzono ostatnią aktualizację z nim związaną.

Od czasu wprowadzenia licznych algorytmów poprawiających sposób oceniania stron internetowych na znaczeniu zyskał content marketing.

Obecnie serwisy internetowe są niezwykle ostrożne podczas tworzenia treści, która jest jednym z elementów poprawnej optymalizacji niezbędnej do pozycjonowania. Serwisy dbają o content i pilnują, aby wyszukiwarka Google nie ograniczyła ich zasięgów.

Aktualnie content tworzy się pod internautów, a dopiero później zwraca się uwagę na roboty sieciowe, które regularnie zaglądają na każdą stronę internetową.

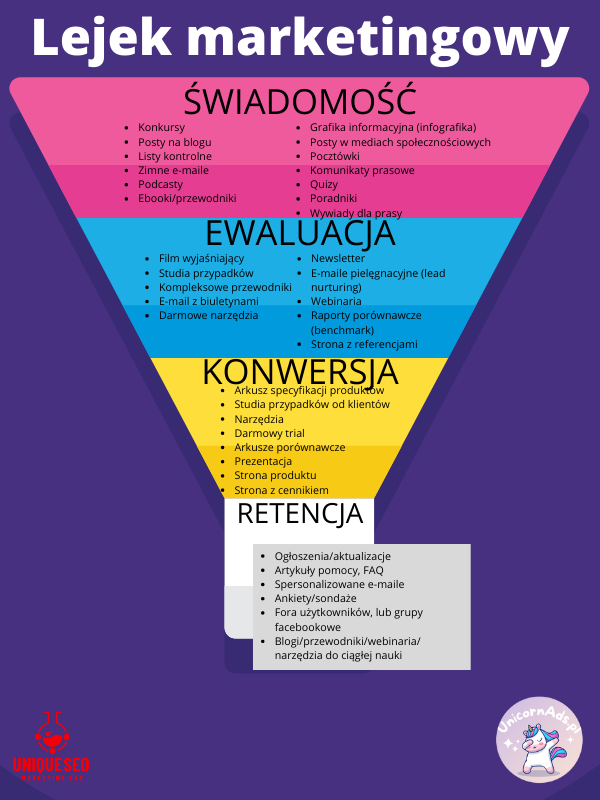

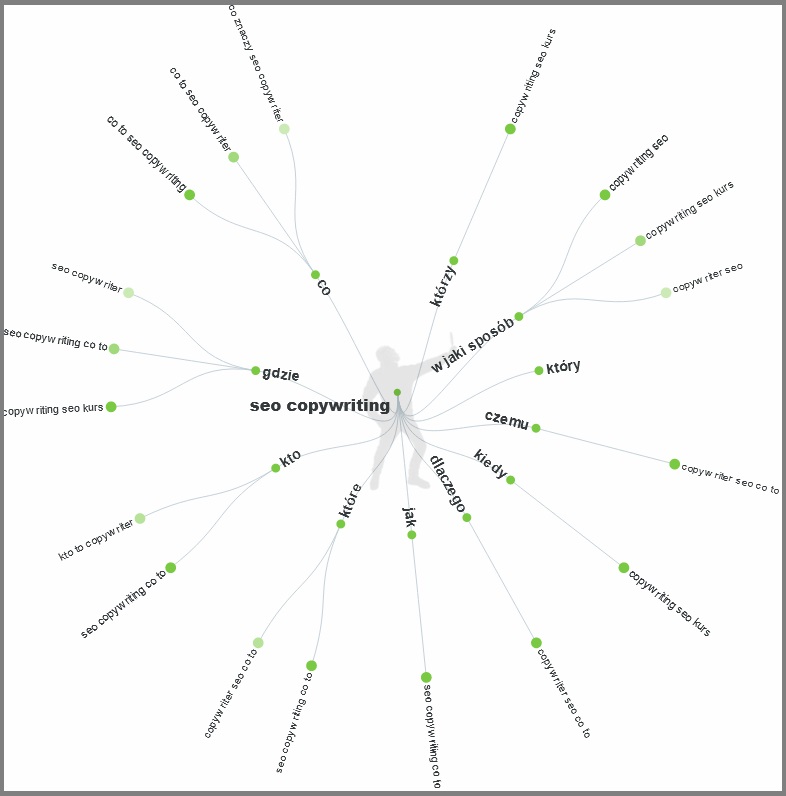

Jak prawidłowo tworzyć treść na stronę www?

Autorzy tekstów muszą pilnować, aby treść tworzona na strony internetowe była unikalna. Oznacza to, iż treść nie powinna znajdować się na innych stronach www, które istnieją już w przestrzeni Internetu.

Oryginalna treść jest lepiej oceniania przez robota Google i prezentuje wyższą wartość. Aktualnie treść powinno tworzyć się w zgodzie z panującymi zasadami SEO i content marketingu.

Właściciele stron powinni starać się, aby teksty dodawane na stronie były interesujące dla internautów. Kolejną kwestią są najróżniejsze materiały dodatkowe, które warto uwzględnić podczas udostępniania treści. W przygotowanym artykule można umieścić interesujące grafiki, materiały wideo lub zdjęcia. Warto tutaj wspomnieć, iż artykuły na stronie powinny być nieustannie aktualizowane.

Nierzadko informacje zawarte w wybranym artykule mogą z czasem ulec zmianie, co będzie wprowadzać czytelnika w błąd. Wyszukiwarka Google zdecydowanie preferuje treści, które przekazują bieżące informacje i są aktualne.

Tworząc treść na stronę internetową należy pamiętać o odpowiednim sformatowaniu. Odpowiednio sformatowany artykuł jest przejrzystszy i przyjemniej się go czyta. Autor powinien podkreślić i pogrubić w artykule te informacje, które mogą być istotne dla czytelnika. Pogrubienia w tekście mogą być istotne dla robota Google, który sprawdza treść pod tym kątem i traktuje ją priorytetowe.

W pogrubionym tekście lub nagłówkach, można ukryć słowo kluczowe, które będzie miała wpływa na SEO.

Kolejną kwestią jest poprawność tekstu pod kątem merytorycznym. Autor powinien zadbać o to, aby tekst był wysokiej jakości i nie zawierał błędów. Robot Google dokładnie sprawdza treść pod kątem błędów stylistycznych i ortograficznych.

Dodając tekst z błędami musimy liczyć się z tym, że nasza strona zostanie gorzej oceniona przez algorytmy. Błędy w tekście są również nielubiane przez internautów, którzy zwracają uwagę na wszelkie mankamenty.

Ostatnią kwestią jest długość tekstu, która także ma znaczenie dla robotów sieciowych współpracujących z wyszukiwarką Google. Aktualnie Google preferuje teksty, które są długie i dogłębnie wyczerpują dany temat. Zdecydowanie nie zaleca się dodawać tekstów, które są krótkie i pobieżnie opisują dane zagadnienie. Im dłuższy tekst, tym zostanie to lepiej odebrane przez wyszukiwarkę Google.

Duplicate content w obrębie Twojej domeny

Zduplikowane meta tagi na stronie: każdy z nas chyba pamięta ze starego GSC (jeszcze wtedy webmaster tools) taki komunikat (w szczególności na kilku stronach bloga):

Największy niekorzystny wpływ mają duplikaty tytułu <title>, a także <h1>.

Jak uniknąć kary za duplikację treści?

Duplicate content to poważny problem, który może przyczynić się do gwałtownych spadków w rankingu Google. Właściciele stron powinni unikać kopiowania treści, która jest niezwykle surowo oceniana przez roboty sieciowe.

Warto tutaj wspomnieć, iż zduplikowana treść może pojawić się nieświadomie na stronie, gdzie pojedyncze zdania się nałożą. Niekiedy będzie to spowodowane przypadkiem lub nieuwagę ze strony autora tekstu.

Wyszukiwarka Google najsurowiej ocenia teksty, które są w całości skopiowane i łamią prawa autorskie. Skopiowana treść może być powodem otrzymania kary w postaci usunięcia z rankingu Google. Strona przestanie się wyświetlać na liście wyszukiwań, a jej utrzymanie stanie się nieopłacalne.

Dbając o właściwą optymalizację strony należy dodawać unikatową treść, która będzie interesująca dla użytkowników Internetu. Każdy właściciel witryny internetowej może sprawdzić swoją stronę pod kątem duplikowania treści.

Do znalezienia zduplikowanej treści można użyć specjalnych narzędzi SEO, które z dużą skutecznością wykrywają podobny tekst. Jednym z popularnych narzędzi internetowych jest Copyscape, które działa już od 2004 roku.

Narzędzie pozwala właścicielom stron wykryć zduplikowany content w obrębie jednej domeny lub na innych stronach funkcjonujących już w przestrzeni Internetu. Narzędzie jest dostępne w opcji bezpłatnej, ale jedynie w ograniczonej wersji. W sieci dostępne są również inne narzędzia lub sposoby, które mogą umożliwić wykrycie powielonej treści.

Pomocna w znalezieniu powielonej treści może okazać się wyszukiwarka Google. Do wykrycia zduplikowanej treści wystarczy skopiować dany fragment tekstu i następnie wkleić go w pole wyszukiwania.

Następnie wyszukiwarka Google ukaże linki prowadzące do stron internetowych, gdzie znajduje się podobny fragment tekstu. Sposób ten jest niezwykle prosty i może go wykorzystać każdy właściciel strony internetowej.

Warto jednak pamiętać, iż czasami duplikacja treści jest normalnym zjawiskiem. Do powielania treści najczęściej dochodzi w obrębie podstron, które dotyczą wybranego sklepu internetowego.

Strony należące do sklepów internetowych niekiedy każdego dnia dodają setki nowych produktów, które mogą być opisywane w podobny sposób. Niektóre identyczne produkty mogą pojawiać się w różnych sklepach, gdzie opisy będą nieznacznie podobne do siebie.

Czym jest Copyscape i jak pomaga w duplicate content?

Copyscape to narzędzie, które zostało stworzone do walki z duplicate content, czyli zplagiatami pojawiającymi się w przestrzeni Internetu. Narzędzie jest używane przez właścicieli stron, którzy chcą odnaleźć skradzioną treść. Nierzadko dochodzi do sytuacji, że internauci kopiują treść z innej strony www bez pozwolenia.

W najgorszym przypadku treść duplicate content pojawia się w identycznej wersji na stronie osoby, która ją wcześniej skopiowała bez stosownego pozwolenia. Takie działanie jest traktowane jako kradzież i z premedytacją łamie prawa autorskie.

REKLAMA

Koniecznie zobacz NAJLEPSZE szkolenie z Facebooka na rynku

Link do kursu: szkolenie Facebook Ads

Koniec reklamy.

Copyscape błyskawicznie sprawdza Internet pod kątem powielonej treści i informuje o tym jej właściciela o zaistnieniu duplicate content. Mając świadomość o dokonanej kradzieży i złamaniu praw autorskich, właściciel tekstu może podjąć stosowne kroki. Jest to niezwykle przydatne narzędzie, które stworzyła firma o nazwie Indigo Stream Technologies. Do sprawdzenia strony pod kątem powielonej treści wystarczy jej adres lub fragment tekstu, który chcemy zbadać. Następnie narzędzie udostępnia nam w formie raportu listę stron www, gdzie znajduje się podobny fragment tekstu. Warto tutaj wspomnieć, iż właściciel strony może podpiąć narzędzie Copyspace do swojego serwisu internetowego.

Narzędzie do wyszukiwania duplicate content będzie wówczas informować właściciela o pojawiającej się w przestrzeni Internetu zduplikowanej treści. Jest to skuteczna ochrona przed ewentualną kradzieżą, która może się zdarzyć każdemu twórcy. Powiadomienie o znalezionej kopii w Internecie jest wysyłane na e-mail.

Opcja jest jednak płatna i można z niej skorzystać jedynie w wersji Premium, która dostaniemy po wykupieniu stosownej licencji. W Internecie są dostępne również inne narzędzia, które można wykorzystać do sprawdzania powielonej treści.

Innym znanym narzędziem jest Ahrefs, gdzie także znajduje się opcja umożliwiająca wykrywanie duplikacji treści w sieci. Narzędzie Ahrefs podobnie jak Copyscape, jest dostępne w ograniczonej wersji bezpłatnej i płatnej, gdzie funkcjonalność jest rozszerzona.

Podsumowanie wpisy na temat duplicate content

Teraz chciałbym usłyszeć od Ciebie:

Który fragment artykułu był dla Ciebie najbardziej zaskakujący?

A może masz jakieś pytanie.

Tak czy inaczej, zostaw teraz krótki komentarz poniżej.

Co myślisz o moim nowym wpisie na blogu?

A może masz pytanie dotyczące strategii lub techniki jak działać najlepiej?

Tak czy inaczej, chciałbym usłyszeć, co masz do powiedzenia.

Więc śmiało, teraz udostępnij ten wpis na swoich social mediach i zobacz co inni mają do powiedzenia.